> FocusUnimore > numero 8 – ottobre 2020

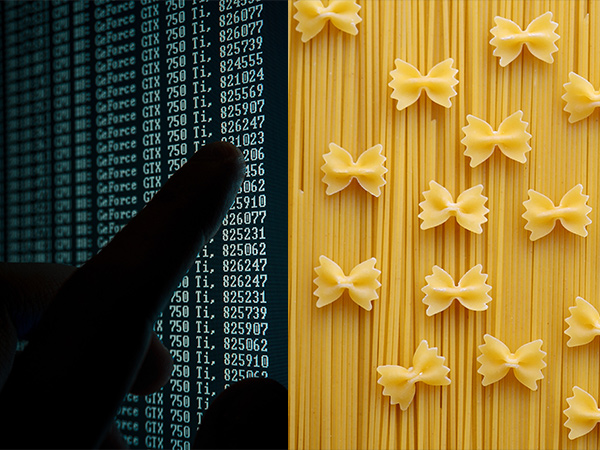

La chemiometria – ovvero la branca della chimica che studia l’applicazione di metodi matematici o statistici ai dati chimici – si mette al servizio delle eccellenze agroalimentari del nostro territorio, tramite l’analisi di big data.

È questo uno degli obiettivi del lavoro della Prof.ssa Marina Cocchi del Dipartimento di Scienze Chimiche e Geologiche, che con il suo team lavora allo sviluppo di algoritmi per analizzare set di dati complessi utili a individuare frodi alimentari o non conformità dei prodotti alimentari agli standard richiesti, nell’ambito della COST Action “European Network for assuring food integrity using non-destructive spectral sensors” (SensorFINT), appena avviata.

Da molti anni il gruppo della Prof.ssa Cocchi si occupa infatti dell’analisi chemiometrica di big data in due filoni principali: il monitoraggio dei processi industriali; e il controllo qualità e di autenticità dei prodotti alimentari.

Con “Big Data”, come è noto, si intendono principalmente i dati che derivano dai cosiddetti “sensori di processo”, quali misuratori di pressione, portata, temperatura presenti in attività industriali; altri dati largamente utilizzati in questo tipo di analisi sono quelli derivanti da sensori più strettamente chimici, quali dati di origine spettroscopica (la spettroscopia NIR, la fluorescenza, l’imaging Raman o iperspettrale), o dati di natura cromatografica che registrano composizione e caratteristiche chimico-strutturali del prodotto in fase di realizzazione. Negli impianti di produzione sono infatti normalmente installati un gran numero di questi sensori, che generano un’enorme mole di dati.

Queste strumentazioni vengono utilizzate allo scopo di controllare la produzione per ridurre le carenze e i difetti di produzione generati da malfunzionamenti fortuiti degli impianti, o da condizioni non ottimali raggiunte a causa della complessità del processo. È però possibile utilizzare questi dati per un altro scopo. Utilizzando modelli matematico-statistici adeguati – e qui entra in gioco il lavoro della Prof.ssa Cocchi e del suo team – è possibile estrapolare da quella mole di dati le informazioni utili, da un lato, a predire le proprietà che definiscono la qualità del prodotto finito in tempo reale e, dall’altro, di riportare il processo in condizioni operative normali, una volta compreso come ogni fase della produzione influenza le caratteristiche finali del prodotto.

In un normale processo di produzione, infatti, il controllo avviene tramite l’analisi di dati derivanti da punti di monitoraggio selezionati – considerati solitamente i più critici – e si basa in maniera rilevante sull’esperienza delle figure professionali addette al monitoraggio. Un approccio di questo tipo mostra i propri limiti quando molti parametri cambiano simultaneamente, in virtù della interdipendenza di molte di esse. L’approccio, perseguito dal gruppo della Prof.ssa Cocchi invece di concentrarsi sulle singole variabili, utilizza modelli matematico-statistici che tengono conto dell’intero gruppo di variabili di processo e della loro correlazione. In questo modo è possibile operare la compressione dei dati acquisiti da un gran numero di sensori in poche variabili, tenendo in considerazione la correlazione tra i parametri di processo, e quindi monitorare la produzione tramite queste poche variabili (idealmente, solamente due).

Un grande vantaggio di questo approccio è che non solo è efficiente per identificare le anomalie, ma anche per diagnosticarne le possibili cause. In tal modo diventa possibile individuare le anomalie, reimpostare i parametri dell’impianto, cambiare la materia prima ecc., quindi tutti i possibili eventi che causano un cambiamento delle condizioni del processo. Questi strumenti e modelli possono essere implementati in tempo reale, in modalità predittiva, ed essere poi visualizzati mediante interfaccia grafica di semplice interpretazione per gli addetti agli impianti.

La difficoltà nell’utilizzo di questi dati sta nella messa a punto e ottimizzazione di algoritmi che permettano di individuare anomalie o variazioni rispetto alla normalità della produzione, e nella loro validazione.

Questo tipo di approccio è applicato oggi dalla Prof.ssa Cocchi in almeno due contesti, nell’ambito di un progetto finanziato dalla Regione Emilia-Romagna sul bando dal titolo “Progetti per le alte competenze per la ricerca e il trasferimento tecnologico” finalizzato a costruire e trasferire nuove competenze necessarie allo sviluppo del sistema economico della Regione.

Il primo ambito di applicazione e sviluppo riguarda l’industria dei polimeri, e vede la collaborazione dell’azienda Versalis-ENI, che rappresenta una realtà̀ avanzata nell’utilizzo di un approccio basato su big data per il monitoraggio della propria produzione. Il secondo è relativo all’industria alimentare e vede la collaborazione di un gigante del settore, ovvero Barilla. Questo secondo ambito è certamente più complesso e di frontiera, dato che riguarda un settore che vede una presenza molto più limitata di sensori di processo nella produzione, e dove le materie prime di tipo agronomico e le formulazioni (ovvero, le ricette) sono molto più variabili.

La collaborazione con Barilla rispecchia l’attenzione dell’industria agroalimentare per l’approccio basato sui big data nel monitoraggio dei processi di produzione. C’è infatti una crescente necessità per l’industria alimentare di fornire informazioni sui propri prodotti al fine di soddisfare gli standard di qualità e di proteggere i propri prodotti dalle frodi alimentari. Come sottolineato in precedenza, l’ambito agroalimentare mostra un minore utilizzo di sensori di processo “tradizionali”, ma fa grande uso dei cosiddetti sensori spettroscopici non distruttivi come la spettroscopia NIR, la fluorescenza, l’imaging Raman o iperspettrale, che consentono una valutazione rapida, non distruttiva e sicura per l’ambiente, di molti parametri in più prodotti alimentari.

È in questo contesto che è nata, appunto, SensorFINT, un’azione europea COST che ha lo scopo di creare una rete che metta insieme esperienza nella ricerca, produzione, formazione e trasferimento tecnologico in ambito alimentare per garantire l’integrità degli alimenti utilizzando sensori spettrali non distruttivi correlata all’uso di sensori spettroscopici non distruttivi. Numerosi ricercatori e ricercatrici sono coinvolti in questa azione, che ha avviato la sua attività il 30 settembre scorso con il primo meeting on line. In questo contesto, la Prof.ssa Cocchi metterà a disposizione la sua esperienza nell’analisi chemiometrica di big data, contribuendo così allo sviluppo di un “sistema di controllo alimentare intelligente”.